Nowoczesne Data Center w czerwcowym wydaniu magazynu DLP expert !

Świat jest głodny.

Głodem informacji przemożnym. Im więcej danych ma, tym więcej łaknie. W czasach sprzed ery informatycznej, potoki danych ograniczone były wydajnością ograniczonego zbioru „twórców” informacji (trzeba było mieć coś istotnego do powiedzenia i umieć to zrobić), tudzież przepustowością kanałów informacyjnych. „Społeczeństwa informacyjne”, wygenerowane przez maszyny informacyjne powszechnie dostępne, definiowane zgrabnym akronimem 3P (przesyłanie, przetwarzanie, przechowywanie informacji), wytwarzają, przesyłają, przetwarzają i przechowują dane. Zgodnie z definicją. „Britannica 2013 Deluxe DVD” zawiera 82000 haseł, ok. 20000 fotografii, ok. 1300 audio i wideo klipów. Wszystko to mieści się na jednej płycie DVD (4.7GB) i kosztuje tylko $29.95. To wiedza i dane rzetelne bo tworzyły je pokolenia uczonych i ludzi tworzących naszą teraźniejszość…

Dane generowane w trakcie eksperymentów w LHC (CERN) wymagają obecnie ok. 5.5 PB przestrzeni dyskowej, która jest podwajana co ok. 3 lata. Te dane to naszej cywilizacji przyszłość i współczesność, a CERN to także choćby PET (positron emission tomography) i takie trywialne wynalazki jak WWW, która trafiła pod przysłowiowe „strzechy”. Ilość informacji można dokładnie określić, znamy bowiem, dzięki teorii informacji Claude’a E. Shannona, jej miary.

Gorzej jest z jakością informacji. Nie ma sposobu by ją zdefiniować chociaż wielu próbowało, m.in. prof. Marian Mazur, który stworzył oryginalną teorię opisującą ilość i jakość informacji. Mimo to problem pozostał nierozwiązany a o wartości informacji decyduje jej użytkownik, jak przystało na bazarowy charakter naszej cywilizacji. Użytkownikami informacji są, lub mogą być, wszyscy. Google, AppleStore, Twitter, GPS, GSM czy magiel cyfrowy – Facebook, to jest coś dla mas. Ale obok jest ,,władza’’. Ogromnie pazerna, głodna informacji o wszystkim, która ma środki i je wykorzystuje by dane pozyskiwać.

W początkowych latach „zimnej wojny”, bo już w roku 1948, USA i Wielka Brytania utworzyły zręby globalnego systemu pozyskiwania danych telekomunikacyjnych, do którego nieco później włączone zostały Kanada, Australia, i Nowa Zelandia, jako członkowie (Brytyjskiej) Wspólnoty Narodów. System nazwano Echelon. Ten bezprecedensowy system działa do dzisiaj i obecnie jest klasyfikowany jako wywiad gospodarczy o globalnym zasięgu. Dla „odpowiednich” czynników dane pozyskiwane przez ten system mają wartość wymierną w środkach generowanych wirtualnie przez System Rezerwy Federalnej. 6M$ bowiem był wart przetarg na dostawę samolotów dla Arabii Saudyjskiej, który przegrał europejski Airbus dzięki danym Echelon’a http://news.bbc.co.uk/2/hi/europe/820758.stm. W roku 2001 agencja STOA Parlamentu Europejskiego opublikowała raport „w sprawie Echelon’a” http://cryptome.org/echelon-ep-fin.htm. Potem jest Julian Paul Assange i jego WikiLeaks a teraz Edward Snowden i PRISM. I co dalej?

Najnowszy DLP expert można bezpłatnie pobrać tutaj

Przypominamy aby otrzymywać prenumeratę wydania drukowanego wystarczy zarejestrować się na stronie

W numerze 2/2013

Aktualności

Budowa Centrów Przetwarzania Danych

Infrastruktura właściwa dla większych CPD

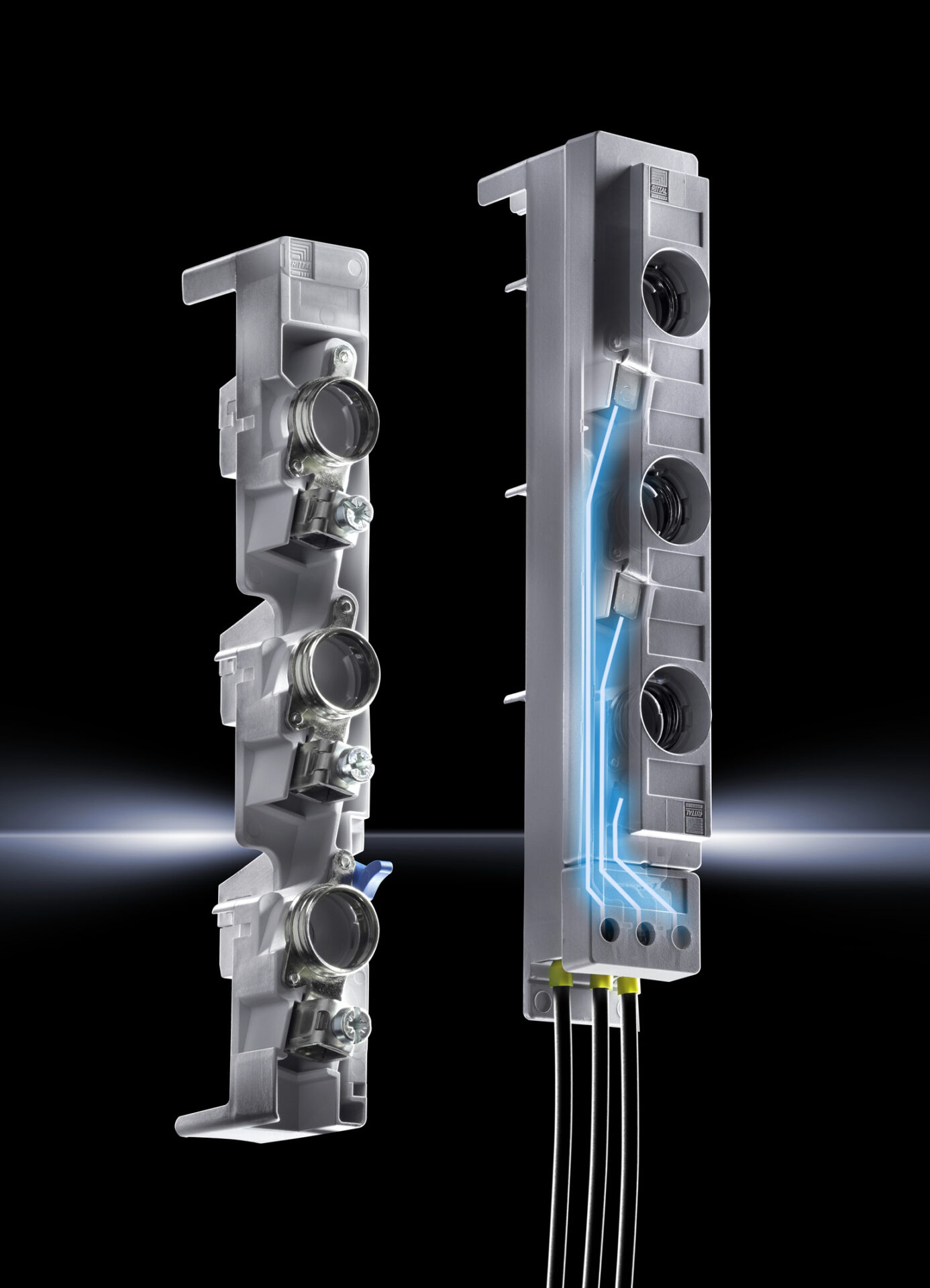

Infrastruktura fizyczna CPD – wyposażenie Data Center

Najnowocześniejsze centrum danych IBM w Polsce

Backup w Data Center

HP Moonshotsystem – skok na Księżyc i jeszcze dalej!

Case study – pierwsza tak zaawansowana integracja w Polsce

Big Data – kilka słów o bezpieczeństwie

Nowoczesne Data Center – Onet.DataCenter

Normy poziomu dostępności TIER

Nowoczesne Data Center – Linxdatacenter

Bezpieczna i oszczędna serwerownia

Ochrona danych osobowych w administracji publicznej

Bezpieczne systemy dla Data Center – Windows Server 2012

Czyszczenie data center

Bezpieczeństwo centrów przetwarzania danych

Big Data wymaga stosowania wydajniejszych rozwiązań

SAN vs. NAS

Ontrack EasyRecovery w akcji – historia pewnego przypadku

PR

LA